Ya han empezado las Ofertas Prime de Amazon!!! Muy buenas ofertas para los clientes Prime... Date prisa antes de que se acaben!!

Ver ofertasLa Organización Europea para la Investigación Nuclear (CERN) alberga uno de los proyectos científicos y de ingeniería más ambiciosos jamás emprendidos por el ser humano. El Gran Colisionador de Hadrones (LHC) es el acelerador de partículas más grande y de mayor energía del mundo, utilizado por los científicos para analizar pruebas de la estructura del mundo subatómico; en ese proceso, el LHC es capaz de generar decenas de petabytes de datos cada año.

El CERN ha tenido que actualizar recientemente sus sistemas informáticos para preparar la nueva fase experimental del Gran Colisionador de Hadrones (LHC Run 3). Se espera que esta fase genere 1 petabyte de datos al día hasta finales de 2025. Los anteriores sistemas de bases de datos ya no eran suficientes para manejar los datos de “alta cardinalidad” producidos por los experimentos primarios del colisionador, como el CMS.

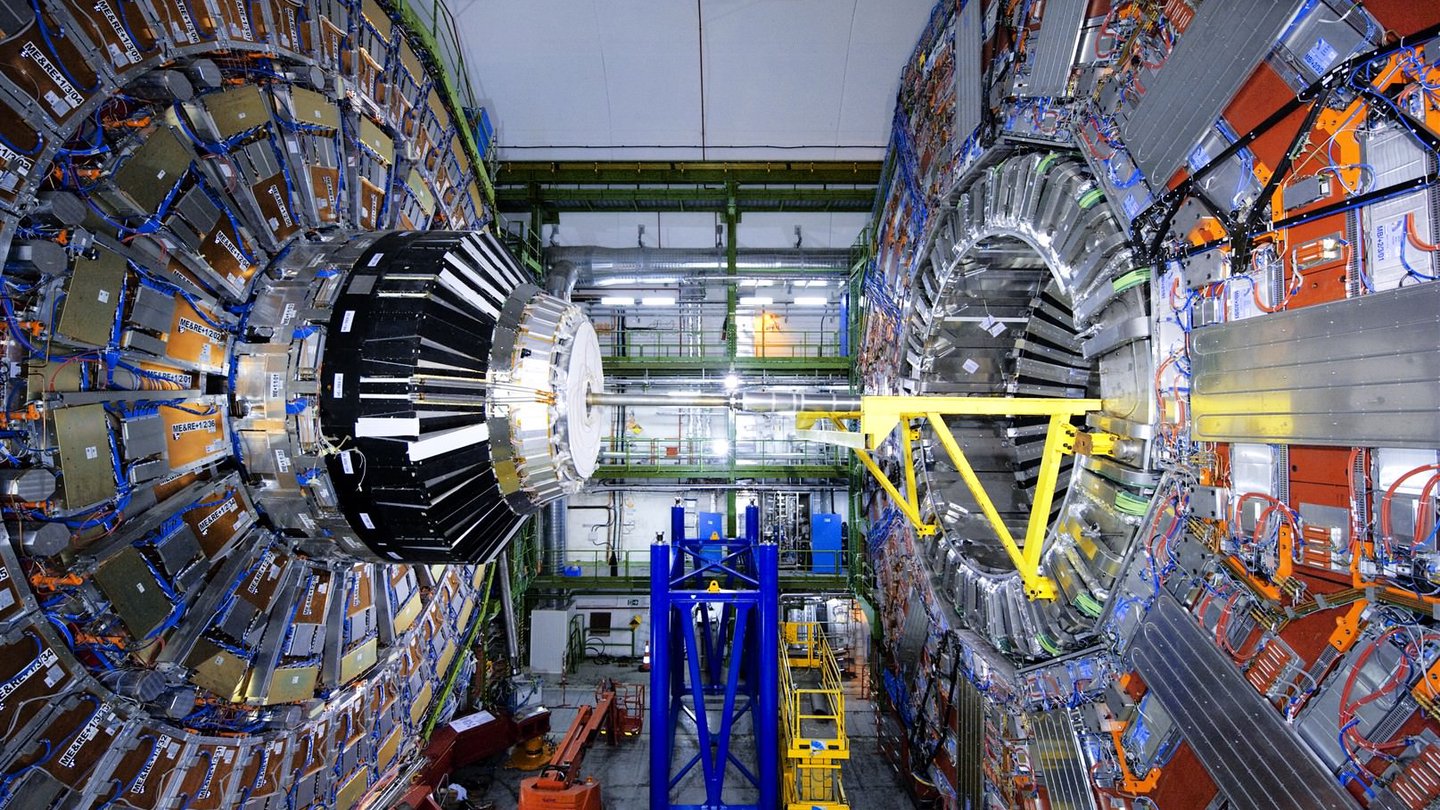

El Solenoide Compacto de Muones (CMS) es el detector de propósito general del LHC con un amplio programa de física. Abarca el estudio del Modelo Estándar (incluido el bosón de Higgs) y la búsqueda de dimensiones extra y partículas que puedan constituir la materia oscura. El CERN describe este experimento como una de las mayores colaboraciones científicas de la historia, en la que participan aproximadamente 5.500 personas de 241 institutos de 54 países diferentes.

CMS y otros experimentos del LHC se sometieron a una importante fase de actualización de 2018 a 2022 y ahora están preparados para reanudar la colisión de partículas subatómicas durante el período de tres años de recopilación de datos “Run 3”. Durante la parada, los expertos del CERN también realizaron mejoras sustanciales en los sistemas detectores y las infraestructuras informáticas que dan soporte a CMS.

Las operaciones del Run 3 generan una mayor luminosidad, lo que se traduce en un aumento sustancial del volumen de datos. El anterior sistema de monitorización backend se basaba en la base de datos de series temporales (TSDB) de código abierto InfluxDB, que utiliza algoritmos de compresión para gestionar eficazmente estos datos, junto con la base de datos de monitorización Prometheus.

Sin embargo, InfluxDB y Prometheus se encontraron con problemas de rendimiento, escalabilidad y fiabilidad, sobre todo cuando se trataba de datos de alta cardinalidad. La alta cardinalidad se refiere a la prevalencia de valores repetidos y a la capacidad de redistribuir aplicaciones varias veces en nuevas instancias. Para hacer frente a estos retos, el equipo de monitorización de CMS optó por sustituir InfluxDB y Prometheus por la base de datos VictoriaMetrics TSDB.

VictoriaMetrics sirve ahora tanto de almacenamiento backend como de sistema de monitorización para CMS, lo que resuelve eficazmente el problema de cardinalidad que se planteaba antes.

El equipo del CMS está actualmente satisfecho con el rendimiento de los clústeres y los servicios. Aunque todavía hay margen para la escalabilidad, los servicios están funcionando en “modo de alta disponibilidad” dentro de los clústeres Kubernetes dedicados del CMS para ofrecer mayores garantías de fiabilidad. El centro de datos del CERN depende de un servicio OpenStack que se ejecuta en un clúster de robustas máquinas x86.